Le rapport entre intelligence artificielle et emploi nécessite de repenser en profondeur l’analyse des tâches dans une entreprise. Il se joue à deux niveaux : dans la compréhension des chaînes de valeur de l’entreprise et dans la capacité des dirigeants à l’appréhender. L’enjeu ? Identifier avec précision où et comment injecter l’IA. Car celle-ci peut mentir, inventer des références et se tromper.

Les sombres prédictions sur la disparition des emplois intellectuels d’entrée de carrière alimentent un débat déjà ancien sur la fongibilité du travail face aux avancées de l’intelligence artificielle (IA) – soit le remplacement d’un emploi par un autre.

Et si la véritable question n’est pas ce qui peut être substitué, mais par où et comment cette substitution crée ou détruit de la valeur pour l’entreprise ? C’est que nous soulignons dans notre étude réalisée par le Global Partnership on AI (GPAI) et le Centre d’expertise international de Montréal en intelligence artificielle (Ceimia).

L’enjeu pour l’intelligence artificielle est de dépasser l’identification par catégorie des emplois, et plus finement des tâches automatisables, pour comprendre leur position stratégique dans la chaîne de création de valeur.

Encore aujourd’hui, l’essentiel des études sur l’impact de l’IA dans le domaine procède par décomposition : identifier des tâches, évaluer la capacité de celles-ci à être automatisées, agréger les résultats. Cette méthodologie, héritée de Carl Benedikt Frey et Michael Osborne, qui estimaient que l’automatisation présentait un risque pour 47 % des emplois, comprend des limites.

Elle ignore la fonction économique spécifique de chaque tâche prise individuellement dans la définition d’un emploi, mais aussi le processus de création de valeur.

Alors où et comment l’IA peut-elle avoir une valeur ajoutée dans l’entreprise ? Comment les dirigeants peuvent-ils s’en emparer pour être le meilleur architecte des interactions homme-machine ? Comment accompagner cette transition ?

Scandale Deloitte Australie

Le scandale Deloitte d’octobre 2025 illustre cette problématique. Deloitte Australie a dû rembourser partiellement une facture de 440 000 dollars australiens (environ 248 000 euros). Pourquoi ? Un rapport commandé par le gouvernement s’est révélé avoir été produit avec Azure OpenAI GPT-4o… sans divulgation initiale.

Le travail contenait des références académiques inexistantes, des citations inventées et des experts fictifs. Qui plus est, une fois ces problèmes détectés, le cabinet a substitué aux fausses références d’autres bien réelles, qui ne soutenaient pas les conclusions initiales du document.

Deloitte avait été choisi, non pas pour ses capacités rédactionnelles, mais parce qu’il apportait une assurance d’expertise indépendante, une garantie de fiabilité des sources, un engagement de responsabilité professionnelle. En automatisant sans contrôle, le cabinet a détruit précisément ce pour quoi il était payé.

Références inexistantes

Ce phénomène n’est pas isolé. Une étude du Cureus Journal of Medical Science montre que sur 178 références citées par une IA, 69 renvoyaient à des références incorrectes ou inexistantes. Plus troublant encore : des termes fictifs se propagent désormais dans la littérature scientifique réelle après avoir été générés par l’IA.

Cette asymétrie révèle que la « valeur » d’une tâche dépend autant de sa place dans la chaîne de production que de son « rôle » à l’égard des autres tâches, de la manière dont elle les influence.

L’impact délétère de l’usage de l’IA dans ce type de contexte a été illustré par le cas de l’assistant médical Nabla. Fin 2024, l’outil proposé par cette société permettant une prise de note automatisée dans le domaine médical avait été utilisé par plus de 230 000 médecins et 40 organisations de santé. Il avait permis la transcription de 7 millions de consultations.

À cette date, une étude a révélé que le logiciel avait inventé des phrases entières, faisant référence à des médicaments inexistants, comme « hyperactivated antibiotics », des commentaires non prononcés… le tout dans un contexte où tous les enregistrements audio des patients concernés avaient été effacés, rendant impossible une quelconque vérification a posteriori.

Cerner la tâche automatisable avec l’IA

À l’ère de l’IA, il faut dépasser les seuls critères de destruction d’emplois ou de potentiel d’automatisation pour évaluer chaque tâche selon trois dimensions complémentaires.

Dépendance opérationnelle

La première dimension concerne la dépendance opérationnelle, c’est-à-dire la façon dont la qualité d’une tâche impacte les tâches suivantes. Une forte dépendance, comme l’extraction de données servant à définir une stratégie, exige la prudence car les erreurs se propagent dans toute la chaîne. À l’inverse, une faible dépendance, comme la simple mise en forme d’un document, tolère mieux l’automatisation.

Connaissance non codifiable

La deuxième dimension évalue la part de connaissance non codifiable nécessaire à la tâche. Il s’agit de tout ce qui relève de l’expérience, de l’intuition et du jugement contextuel, impossible à traduire en règles explicites. Plus cette part est élevée, plus il faut maintenir un couplage étroit humain-machine pour interpréter les signaux faibles et mobiliser le discernement humain.

Réversibilité

La troisième dimension concerne la réversibilité, soit la capacité à corriger rapidement une erreur. Les tâches à faible réversibilité, comme un diagnostic médical préopératoire ou la gestion d’infrastructures critiques, exigent une supervision humaine forte, car une erreur peut avoir des conséquences graves. Les tâches réversibles, comme les brouillons ou l’exploration de pistes, acceptent davantage d’autonomie.

Quatre interactions avec une IA

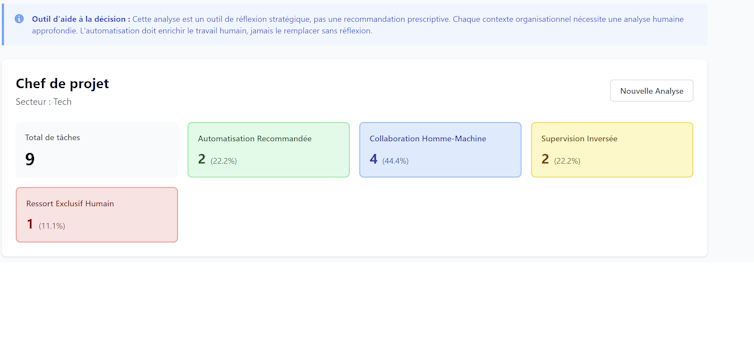

Ces trois dimensions dessinent quatre modalités d’interaction avec l’IA, recommandées en fonction des tâches à effectuer.

L’automatisation est recommandée pour les tâches peu interdépendantes, réversibles et codifiables, comme la mise en forme, l’extraction de données ou les premiers jets.

La collaboration humain-machine convient aux situations de dépendance modérée, mais de haute réversibilité, où les erreurs peuvent être gérées, comme l’analyse exploratoire ou la recherche documentaire.

Certaines tâches demeurent du ressort exclusif de l’humain, du moins pour l’heure. Il s’agit notamment des décisions stratégiques qui cumulent une forte interdépendance des tâches, une part importante de connaissance non codifiable issue de l’expérience et une faible réversibilité des choix effectués.

La supervision inversée s’impose lorsque l’IA produit, mais que l’humain doit valider systématiquement, notamment en cas de forte dépendance ou de faible réversibilité. Le cas Air Canada montre que lâcher la bride à une IA dans un tel contexte est hautement dommageable. Ici, le chatbot de la compagnie aérienne avait affirmé qu’on pouvait demander rétroactivement un tarif spécifique lié à des évènements familiaux, ce qui s’est révélé totalement faux.

Attaquée en justice par le passager qui s’estimait trompé, la compagnie a été condamnée au motif qu’elle était l’entité responsable de l’IA et de son usage. Or, elle ne la supervisait pas. L’impact financier de cette condamnation peut sembler faible (le remboursement du passager), mais le coût tant en termes de réputation que pour l’actionnaire est loin d’avoir été négligeable.

Quatre compétences clés pour un manager

Chaque chaîne de valeur rassemble une grande variété de tâches qui ne se distribuent pas selon une logique uniforme : les quatre modalités d’automatisation se retrouvent entremêlées de manière hétérogène.

Le manager devient alors l’architecte de ces chaînes de valeur hybrides, et doit développer quatre compétences clés pour les piloter efficacement.

- Il lui faut maîtriser l’ingénierie de workflows cognitifs, c’est-à-dire identifier avec précision où et comment injecter l’IA de manière optimale dans les processus.

- Il doit être capable de diagnostiquer les interdépendances opérationnelles propres à chaque contexte, plutôt que d’appliquer mécaniquement des grilles d’analyse externes focalisées uniquement sur le coût du travail.

- « Désintermédiation cognitive » : il s’agit d’orchestrer les nouveaux rapports au savoir créés par l’IA tout en préservant la transmission des compétences tacites qui font la richesse d’une organisation.

- Le manager doit porter une éthique de la substitution, en arbitrant constamment entre l’efficience immédiate qu’offre l’automatisation et la préservation du capital humain sur le long terme.

Un paradoxe technique éclaire ces enjeux. Les modèles de raisonnement les plus avancés hallucinent paradoxalement plus que leurs prédécesseurs, révélant un arbitrage inhérent entre capacité de raisonnement et fiabilité factuelle. Cette réalité confirme que l’impact de l’IA sur le monde du travail ne peut se réduire à une simple liste de métiers condamnés à disparaître.

Les dimensions analytiques présentées ici offrent précisément un cadre pour dépasser les approches simplistes. Elles permettent de positionner le management dans un rôle nouveau : celui d’arbitre et d’urbaniste cognitif, capable de concevoir l’architecture des interactions humain-machine au sein de l’organisation.

Bien conduite, cette transformation peut enrichir l’expérience humaine du travail, au lieu de l’appauvrir.